- Chatbots draaiende op artificial intelligence (AI) werken op basis van zogenaamde ‘large language models’, die gevoed zijn met grote hoeveelheden data.

- Vraagbaken als ChatGPT worden ook getraind door mensen, die de software helpen leren wat een acceptabel antwoord is.

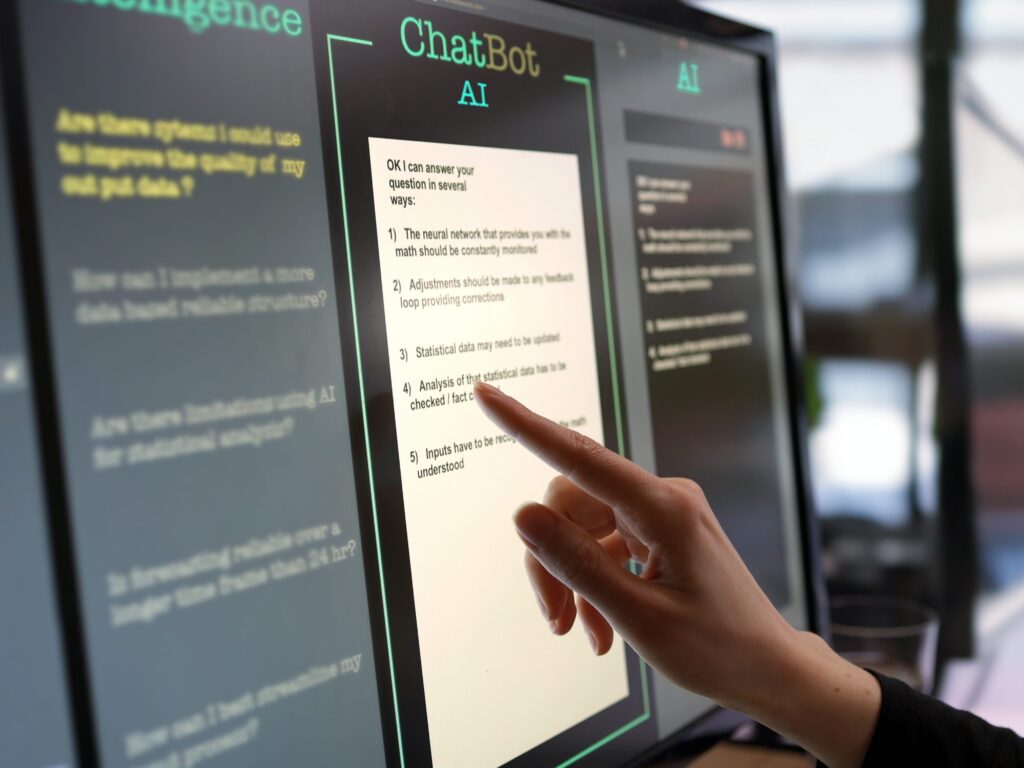

- Hieronder zetten we uiteen hoe chatbots jouw vraag beantwoorden.

- Lees ook: ChatGPT lijkt opeens ‘sneller en dommer’ in plaats van ’traag en precies’, volgens IT-experts – dat kan met een nieuwe, goedkopere opzet te maken hebben

ChatGPT en andere op artificial intelligence (AI) draaiende chatbots kunnen vloeiende en grammaticaal correcte zinnen schrijven die misschien zelfs natuurlijk over kunnen komen.

Maar laat je niet misleiden door te denken dat goed overkomende teksten gedachtes, emoties en intentie communiceren, zeggen experts.

De manier waarop de chatbot werkt, is te vergelijken met een machine die wiskundige calculaties en statistische analyses uitvoert om uit te vinden welke woorden hij kan gebruiken in de gestelde context, aldus de experts. Door veel training – waarbij ook mensen die feedback geven betrokken zijn – kan de bot gesprekken simuleren.

Bots zoals ChatGPT worden ook getraind op gigantische hoeveelheden gesprekken die machines hebben geleerd om interacties met mensen te kunnen hebben. OpenAI, het bedrijf achter ChatGPT, zegt op zijn website dat zijn modellen worden getraind met data uit meerdere bronnen. Hieronder valt bijvoorbeeld ook data van gebruikers.

Zo werken AI-bots als ChatGPT

AI-chatbots, zoals ChatGPT, werken op zogenaamde 'large language models', of LLM's. Dit zijn programma's die getraind worden op grote hoeveelheden tekst, bijvoorbeeld uit online gepubliceerde artikelen.

De systemen worden getraind op woorden die elkaar vaak opvolgen. Ze leren welke woorden belangrijk zijn in die zinnen. Al die opgenomen informatie vergroot niet alleen de feitelijke kennis van de LLM's, het helpt ze ook spraakpatronen te ontdekken en in welke volgorde woorden vaak samen gebruikt worden.

Chatbots worden ook door mensen getraind op hoe ze acceptabele antwoorden kunnen geven, zodat potentieel kwetsende reacties beperkt worden.

Je kunt aangeven dat iets een mening is, zegt directeur Kristian Hammond van het Center for Advancing Safety of Machine Intelligence van Northwestern University. De chatbot zal die reactie in de toekomst dan niet meer genereren.

Als je een chatbot een eenvoudgie, feitelijke vraag stelt, werkt het proces voor het genereren van een antwoord vrij simpel: het gebruikt een aantal algoritmes om de meest voor de hand liggende zin te vinden waarmee hij kan reageren. Binnen enkele milliseconden worden er meerdere potentiële antwoorden gegenereerd, waar de chatbot er een willekeurige uit kiest. Dat verklaart ook waarom de chatbot verschillende antwoorden kan geven op dezelfde vraag.

Een chatbot kan de vraag ook in meerdere delen knippen en vervolgens op elk deel een los antwoord genereren, om daarmee op een uiteindelijk compleet antwoord uit te komen.

Stel je voor dat je vraagt om een Amerikaanse president te noemen die dezelfde voornaam heeft als de hoofdrolspeler uit de film 'Camelot'. De bot kan dan antwoorden dat de acteur Richard Harris heet. Vervolgens kan hij dat antwoord gebruiken om Richard Nixon als antwoord te geven op de originele vraag.

Pas op voor wat chatbots niet weten

Maar wat gebeurt er als je een chatbot een vraag stelt waar hij het antwoord niet op weet? Op dat punt zorgen de vraagbaken voor de meeste problemen. Dat komt voort uit een onderliggend probleem: ze weten niet wat ze niet weten. Ze extrapoleren data op basis van wat ze wel weten, wat eigenlijk betekent dat ze een gokje doen.

Maar ze vertellen je niet dat ze gokken, ze presenteren het antwoord alsof het een feit is. Als een chatbot op deze manier een antwoord verzint en het als feit presenteert, noemen we dat 'hallucineren'.

"Dit noemen we kennis van kennis of metacognitie", zegt hoogleraar computerwetenschappen William Wang van de University of California. Hij is ook mededirecteur van de universitaire groep voor natuurlijke taalverwerking. "Het model begrijpt de bekende onbekenden niet goed", zegt hij.